在 Ollama 中使用 Phi-3

Ollama 允许更多人通过简单的脚本直接部署开源的大型语言模型(LLM)或小型语言模型(SLM),并且可以构建API来帮助本地Copilot应用场景。

1. 安装

Ollama支持在Windows、macOS和Linux上运行。您可以通过这个链接(https://ollama.com/download)安装Ollama。成功安装后,您可以直接使用Ollama脚本通过终端窗口调用Phi-3。您可以查看所有Ollama中可用的库。

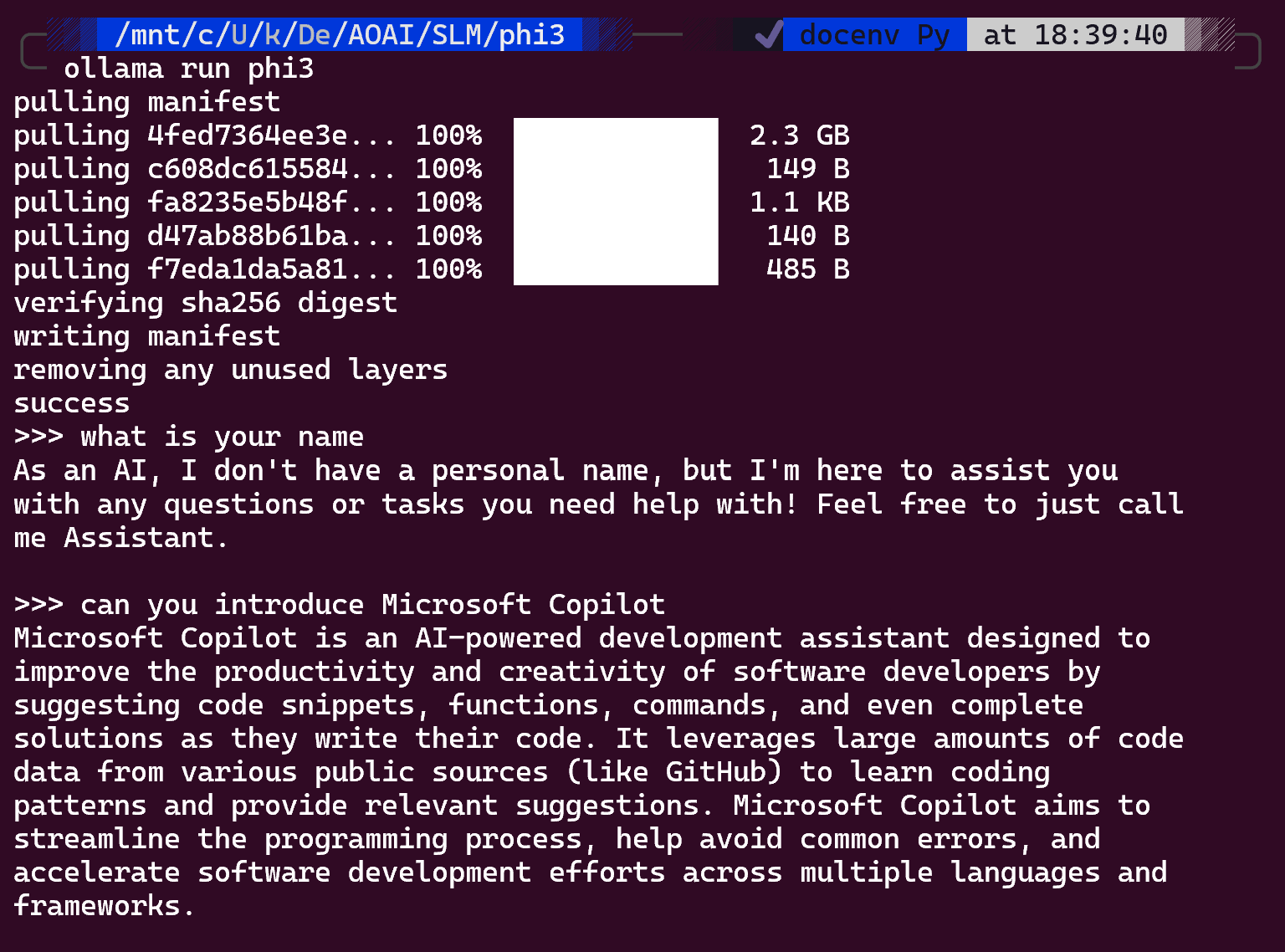

ollama run phi3

注意: 当您第一次运行时,模型会先被下载。当然,您也可以直接指定已下载的Phi-3模型。我们以WSL为例来运行命令。模型成功下载后,您可以直接在终端上进行交互。

2. 从Ollama调用Phi-3 API

如果您想要调用由Ollama生成的Phi-3 API,您可以在终端使用以下命令来启动Ollama服务器。

ollama serve

注意: 如果您使用的是MacOS或Linux,在运行命令时可能会遇到以下错误:"Error: listen tcp 127.0.0.1:11434: bind: address already in use"。当您执行命令时可能会遇到这个错误。解决这个问题的方法是:

macOS

brew services restart ollama

** Linux **

sudo systemctl stop ollama

3. 导出Ollama服务器

- 停止Ollama服务

sudo systemctl stop ollama

3. 导出 Ollama 服务器

- 停止 ollama 服务

sudo systemctl stop ollama

- 修改位于

/etc/systemd/system/ollama.service的 ollama 服务文件,

sudo vim /etc/systemd/system/ollama.service

添加:

[Service]

ENVIRONMENTS="OLLAMA_HOST=0.0.0.0"

ENVIRONMENTS="OLLAMA_ORIGINS=*"

保存并退出。

- 重新加载 systemd 服务并重启 ollama 服务

sudo systemctl daemon-reload

sudo systemctl restart ollama.service

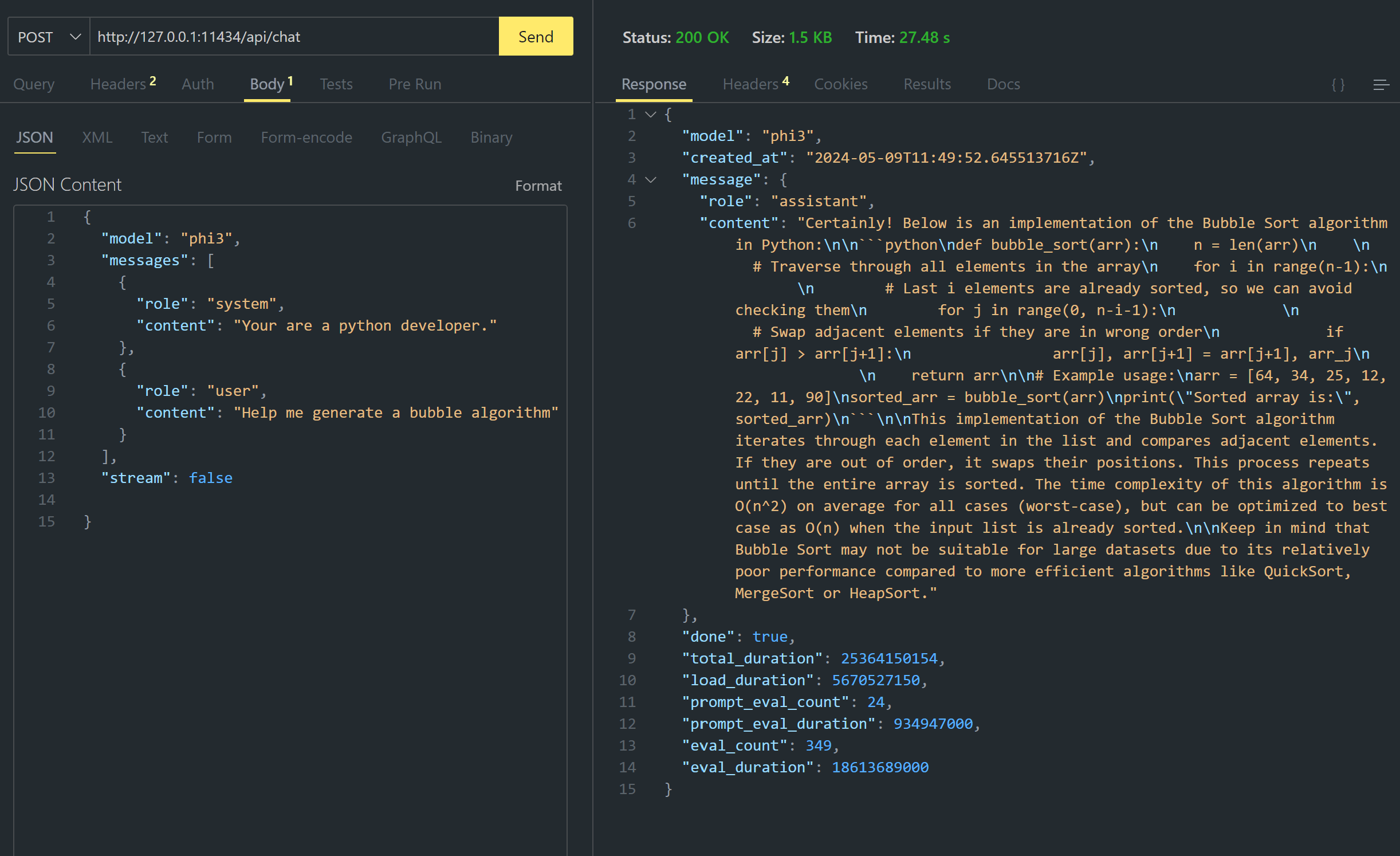

Ollama 支持两个 API:生成和聊天。你可以根据需要调用 Ollama 提供的模型 API。本地服务端口为 11434。例如

聊天

在终端中使用curl命令直接交互:

curl http://127.0.0.1:11434/api/chat -d '{

"model": "phi3",

"messages": [

{

"role": "system",

"content": "Your are a python developer."

},

{

"role": "user",

"content": "Help me generate a bubble algorithm"

}

],

"stream": false

}'

```bash

curl http://127.0.0.1:11434/api/generate -d '{

"model": "phi3",

"prompt": "<|system|>Your are my AI assistant.<|end|><|user|>tell me how to learn AI<|end|><|assistant|>",

"stream": false

}'

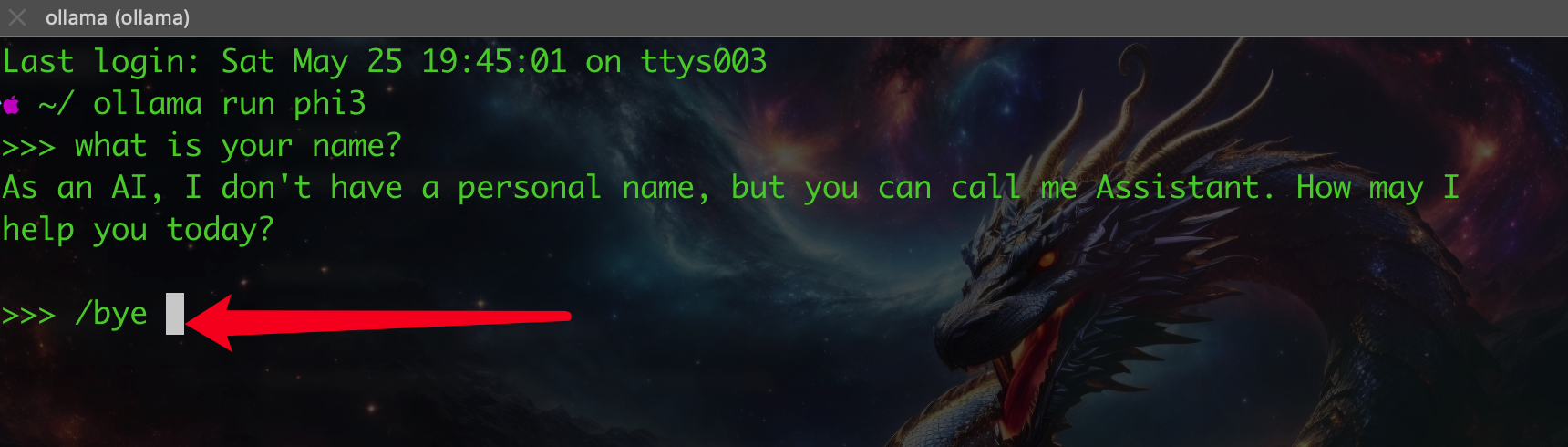

4. 退出 Ollama 提示

- 通过使用

/bye或按下Ctrl + D来退出 ollama。

5. WebUI 部署

-

安装 Nextchat 作为 Ollama API 调用的 WebUI

-

下载链接:Nextchat

-

按照下图配置以下参数:

- 开始你的 AI 之旅,玩得开心!